Le paysage de l’IA évolue rapidement au-delà des LLM et des chatbots. Avec l’introduction de modèles d’IA isolés, les développeurs explorent les prochaines étapes du développement de l’IA : la coordination et la communication entre différents agents d’IA qui offrent des capacités d’automatisation plus avancées aux entreprises.

2025 nous apporte une nouvelle technologie qui permet la connectivité entre les agents d’IA. Au cours des derniers mois, vous avez peut-être entendu une nouvelle série d’acronymes à trois lettres dans le domaine du développement de l’IA. Les protocoles tels que MCP, A2A et ACP sont à l’avant-garde de ce développement.

Le Model Context Protocol (MCP), le Agent-to-Agent Protocol (A2A) et le Agent Communication Protocol (ACP) ouvrent la voie aux systèmes multi-agents. Chacun de ces protocoles cible stratégiquement différentes couches de la communication multi-agents. Ils ne sont pas censés s’exclure les uns les autres, mais ont plutôt des objectifs différents et peuvent se compléter les uns les autres, en fonction des exigences organisationnelles ou commerciales.

Si les protocoles tels que MCP, A2A et ACP constituent la prochaine étape de l’évolution de l’IA, ils ne sont pas tout à fait prêts pour le “prime time” dans le cadre d’utilisations sensibles en entreprise, et ce pour diverses raisons, notamment des problèmes de sécurité. Il ne s’agit pas d’un problème propre à un fournisseur, mais d’une question intrinsèque liée à la maturité des normes sous-jacentes.

Il est également important de comprendre qu’aucun de ces protocoles n’est un pansement magique pour les systèmes numériques immatures présentant des problèmes préexistants. La mise en œuvre d’une solution d’IA avancée dans un paysage d’API instable et immature entraînera plus de dégâts que d’avantages.

L’efficacité et la stabilité des systèmes construits sur la base de protocoles d’IA avancés dépendront fortement d’une base solide de pratiques d’API matures.

Comprendre les principaux protocoles d’IA

Le protocole de contexte de modèle (MCP) permet aux modèles d’IA de s’intégrer à des outils, des API et des sources de données externes, ce qui permet aux entreprises de connecter les LLM à leurs services internes. Il donne aux agents d’IA la capacité de demander des informations ou d’exécuter des actions spécifiques. Des trois protocoles susmentionnés, c’est le plus mature dans le paysage actuel de l’IA agentique, gagnant en traction, à la fois en termes d’adoption par le marché et d’engagement des développeurs.

Pourtant, le MCP est toujours confronté à des problèmes de sécurité non résolus – c’est l’une des raisons pour lesquelles nous disons à la blague qu’il signifie “Plus de contrôle, s’il vous plaît” Les vulnérabilités d’autorisation créent des points d’entrée potentiels pour les attaquants, l’injection rapide menace la fiabilité du système et les fuites de données risquent d’exposer des informations sensibles à des utilisateurs non autorisés.

Le protocole d’agent à agent (A2A ) permet une communication et une collaboration directes entre différents systèmes d’intelligence artificielle. Cette architecture principalement orientée vers l’interne permet aux équipes de mettre en place une collaboration multiplateforme sophistiquée entre différents agents d’IA au sein d’un environnement d’entreprise.

A2A bénéficie d’un soutien important de la part de l’industrie, mais jusqu’à présent, le protocole n’en est qu’à ses débuts.

Le protocole de communication des agents (ACP) propose une approche plus large de la communication en matière d’intelligence artificielle. Il cible les environnements décentralisés et périphériques et aide les agents à communiquer entre différents systèmes, appareils et lieux.

Parmi les trois, ACP est une norme plus récente et plus complexe, qui s’attaque à des scénarios plus difficiles, et cette complexité n’en est encore qu’à ses débuts. Les organisations commencent encore à étudier comment déployer l’ACP en toute sécurité, en particulier dans les systèmes d’IA distribués qui traitent des informations sensibles.

| Caractéristiques | MCP | A2A | ACP |

| Utilisation prévue | LLM ayant besoin de données ou d’outils externes | Flux de travail multi-agents à travers les plateformes | Edge AI, systèmes embarqués, agents hors ligne |

| Architecture | Client-Serveur | Client-serveur avec cartes d’agent | Décentralisé |

| Mécanisme de découverte | Registre du serveur avec outils | Carte d’agent | Diffusion / enregistrement en cours d’exécution |

| Protocole de transport | JSON-RPC 2.0 sur HTTPS | JSON-RPC 2.0 sur HTTPS | IPC, ZeroMQ, gRPC |

| Modèle de sécurité | App-layer Auth, Oauth 2, API délimitées | Oauth2, point de terminaison délimité | Sandboxing, réseau privé |

| Exemple de cas d’utilisation | Connexion d’un LLM à des applications internes | Agentsdistribués et collaboratifs | Coordination de plusieurs agentssur l’appareil |

| Préparation à l’adoption | Adopteur précoce | Adopteur précoce | Preuve du concept |

L’heure de pointe n’a pas encore sonné

Bien que ces protocoles se développent rapidement, ils ne sont pas encore prêts pour une intégration généralisée dans les entreprises, en particulier lorsque des données sensibles sont en jeu. Au stade actuel de leur développement, ces protocoles offrent un potentiel énorme, mais ils rendent également les systèmes vulnérables à de nouveaux risques complexes.

La force de l’IA est aussi sa faiblesse. La capacité des agents à agir, interpréter et communiquer de manière autonome ouvre la boîte de Pandore des erreurs potentielles que les organisations doivent soigneusement gérer. Les systèmes d’IA sous-développés sont susceptibles de faire l’objet d’attaques par empoisonnement des données, ou de corruption des informations dont l’IA tire des enseignements, ce qui peut modifier le comportement des agents. De simples demandes peuvent se transformer en failles de sécurité potentielles.

“Nous sommes en plein dans la phase de la courbe d’engouement et, bien que cela semble différent de certaines vagues technologiques du passé, il est toujours important d’avoir un ensemble équilibré d’attentes et d’agir de manière stratégique.” – Brian Otten, vice-président de la transformation numérique

Les entreprises qui envisagent un déploiement multi-agents doivent comprendre que si ces protocoles ont un potentiel révolutionnaire pour la transformation de l’entreprise, ils nécessitent une base solide et l’acceptation d’un risque plus élevé. L’intégration de ces protocoles nécessite une infrastructure API mature, des contrôles internes stricts et des connaissances spécialisées en matière de sécurité.

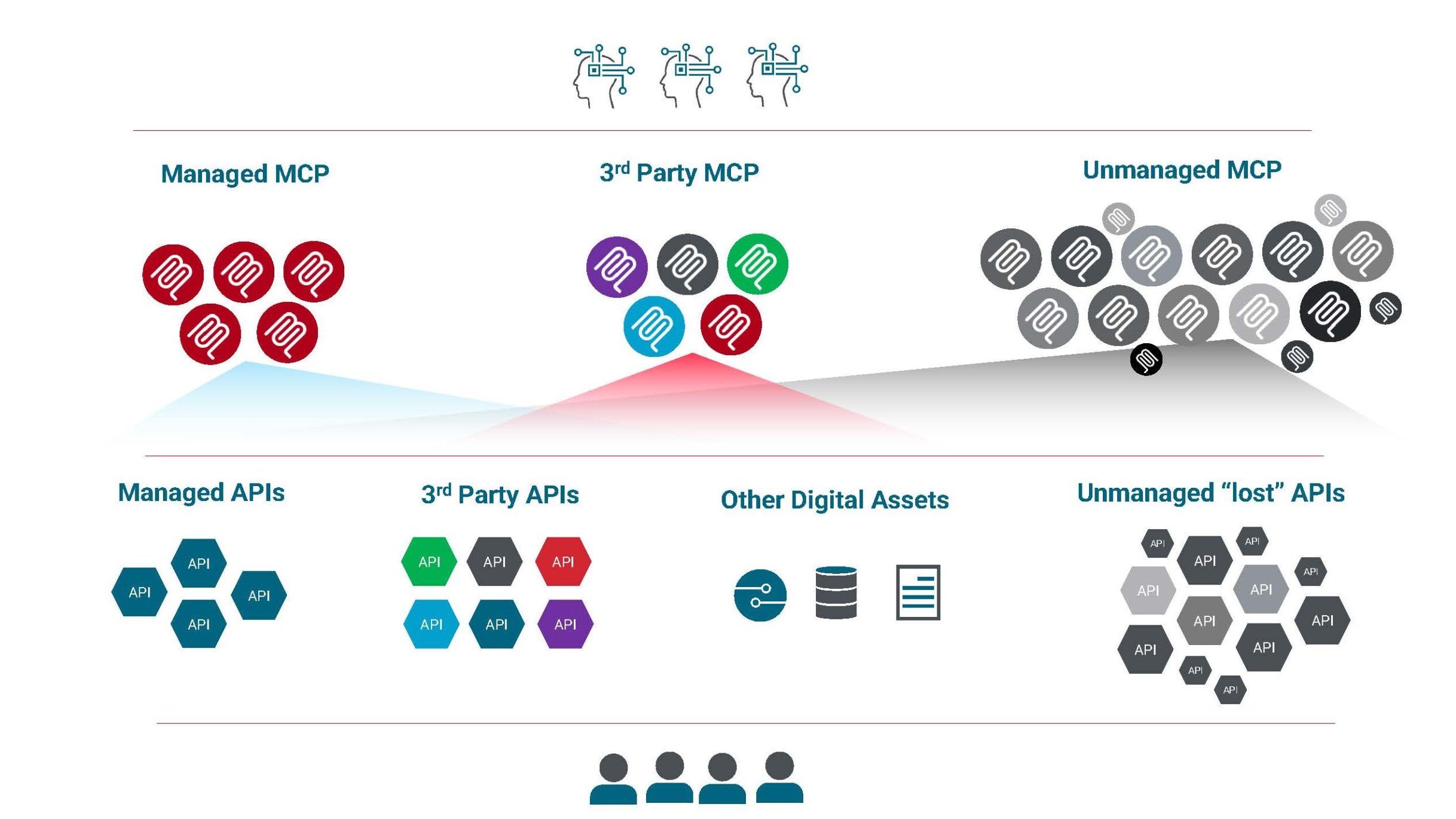

Si l’on prend l’exemple de MCP, celui-ci promet d’envelopper les API existantes et d’autres actifs numériques et d’exposer leurs fonctionnalités d’une manière normalisée, mettant un peu d’ordre dans le chaos et normalisant l’accès pour les LLM. Mais il ne résout pas le chaos lui-même.

Au contraire, il l’aggrave, avec davantage d’actifs numériques, provenant de différentes parties, superposés à votre paysage d’API – en espérant qu’ils soient gérés.

La réalité est qu’avec une base d’API fragile, le MCP ne vous apportera pas les résultats que vous recherchez – conformément au principe “garbage in, garbage out” (“les déchets entrent, les déchets sortent”). Un tout nouveau paysage de chaos se dessine – avec davantage de défis en matière de sécurité en raison de la logique d’engagement fondamentale qui le sous-tend. La maturité et la gouvernance des API sont plus importantes que jamais.

Pour réussir, il faut construire des architectures de sécurité complètes qui vont au-delà des protections intégrées, en se concentrant sur les limites d’exposition et les stratégies de défense multicouches.

L’intégration non déterministe apporte de nouveaux défis (de gouvernance)

Contrairement aux systèmes numériques traditionnels qui fonctionnent selon des schémas hautement prévisibles et reproductibles, les agents d’IA représentent un changement fondamental, passant de schémas d’intégration déterministes à des schémas d’intégration probabilistes. Cette nature non déterministe introduit des défis importants tout au long du cycle de vie.

Résultats imprévisibles : Contrairement aux systèmes conventionnels qui produisent des résultats prévisibles, les agents d’intelligence artificielle peuvent générer des réponses différentes à des entrées identiques. Les tests traditionnels, où l’on s’attend à une correspondance exacte, deviennent inefficaces, ce qui crée des défis sans précédent en matière d’assurance qualité et de validation.

Absence de répétabilité des tests : Ce manque de répétabilité rend les tests cohérents et la reproduction des bogues extrêmement difficiles. Si un test échoue une fois, il est impossible de savoir s’il s’agit d’un véritable bogue qui doit être corrigé ou d’une variation aléatoire dans les résultats du modèle.

Raisonnement opaque (problème de la boîte noire) : La prise de décision complexe et non transparente de l’IA exacerbe ces difficultés. Lorsque les agents enchaînent de multiples étapes de raisonnement et interagissent avec des outils internes, le problème de la “boîte noire” fait qu’il est difficile de comprendre pourquoi un agent a pris une mesure particulière ou est parvenu à une certaine conclusion.

Traitement des erreurs et récupération : La nature dynamique et autonome de l’IA agentique signifie qu’elle peut prendre des décisions et entreprendre des actions qui ne sont pas explicitement codées mais qui sont basées sur ses objectifs et le contexte fourni. Cela expose ces modèles et protocoles à des menaces de sécurité supplémentaires, telles que l’injection d’invite qui peut manipuler l’agent pour qu’il exécute des tâches non autorisées.

Un défi pour la sécurité et la surveillance : La nature non déterministe de l’IA rend également difficile la prévision de l’impact exact sur les systèmes intégrés lorsqu’un modèle d’IA ou son comportement change, par exemple, après qu’un LLM tiers a mis à jour sa version. Cela complique le contrôle des versions, les tests de régression et les retours en arrière fiables en cas de problème.

À ce stade précoce, les entreprises doivent évaluer leur état de préparation organisationnelle pour décider si la voie de l’IA agentique est la bonne solution aujourd’hui.

“Étant donné que les LLM (Large Language Models) comprennent bien le texte et le langage, il est important de connaître les limites de leur utilisation du raisonnement par chaîne de pensée et d’autres techniques appliquées. Les LRM (Large Reasoning Models) sont le lieu de la véritable résolution de problèmes : réflexion étape par étape, impact et cause à effet.” – Brian Otten, vice-président de la transformation numérique

Voir aussi : comment tirer le maximum de valeur commerciale de vos API

Lacunes en matière de sécurité : extension d’OAuth pour l’IA agentique

L’autorité déléguée de l’IA, ou sa nature d’agir “au nom de” son utilisateur, crée le plus grand défi de sécurité pour la mise en œuvre immédiate de protocoles d’IA multi-systèmes.

La nature agentique est beaucoup plus compliquée et plus risquée dans le monde dynamique de l’IA que dans la communication traditionnelle d’application à application. La norme OAuth 2.0, bien que bonne pour l’accès humain, n’est pas suffisante pour les agents d’IA.

Les outils OAuth actuels sont un bon début, mais ils ont besoin d’améliorations importantes pour l’IA. Il est essentiel de vérifier non seulement l’agent, mais aussi qui a donné les autorisations et ce qui a été autorisé. Un agent d’intelligence artificielle peut effectuer des actions non autorisées par accident, s’il interprète une demande différemment de ce qui était prévu, ou avec une intention malveillante, s’il a été piraté par des attaquants.

Les agents d’intelligence artificielle ont besoin d’un accès très spécifique et dynamique, et les autorisations actuelles d’OAuth peuvent être trop générales. Étant donné que ces protocoles impliquent une chaîne d’agents d’intelligence artificielle interagissant les uns avec les autres, il est crucial pour l’audit de prouver qui (ou quoi) a fait quoi, et si cela a été autorisé. Cela nécessite une meilleure journalisation et une preuve cryptographique à chaque étape.

OAuth 2.1 est actuellement un projet de spécification qui améliore la sécurité de base de la manière dont les agents d’intelligence artificielle obtiennent des jetons pour interagir avec les serveurs MCP.

Cependant, la nature interprétative de l’IA, la sélection dynamique des actions et les chaînes de délégation complexes posent des problèmes de sécurité qui vont au-delà de ce qu’un protocole d’autorisation pur comme OAuth 2.1 peut résoudre à lui seul. Cela nécessite une combinaison de mise en œuvre robuste d’OAuth, uneconception architecturale soignée(séparant les serveurs d’autorisation et de ressources), des contrôles de sécurité spécifiques à l’IA tels que des défenses contre l’injection rapide, une gouvernance stricte des données et une surveillance continue.

Comment les entreprises peuvent-elles commencer à mettre en œuvre l’IA agentique ?

La “réponse complète” pour la sécurité MCP est une suite évolutive de technologies, d’outils et de meilleures pratiques.

Outre la prise en charge des nouveaux protocoles, Axway s’attache à fournir à ses clients des outils fondamentaux : une gestion robuste et fédérée des API pour une meilleure gouvernance, des capacités d’intégration transparentes pour connecter des systèmes fragmentés et des fonctions avancées de qualité des données.nous aidons nos clients à normaliser leur paysage d’API, à créer des voies d’intégration sécurisées et à garantir des données propres pour l’ IA agentique.

Nous nous concentrons sur la transformation de la nouvelle couche “spaghetti” en un réseau structuré et fiable. nousdéveloppons la prise en charge du protocole de contexte de modèle (MCP) et faciliterons la communication d’agent à agent (A2A ) afin de créer des passerelles permettant aux agents de collaborer et d’échanger des informations.

Avec Amplify Engage et Fusion, nous sommes extrêmement bien positionnés pour fournir une expérience qui répond aux attentes des entreprises, et qui étend naturellement Engage en tant que centre d’engagement numérique pour les écosystèmes API des clients, à la fois traditionnels et agentiques.

Axway privilégie avant tout la sécurité des systèmes de ses clients lorsqu’elle développe des solutions d’IA transformatrices qui repoussent les limites technologiques. La passerelle IA Amplify AI Gateway accélère votre parcours en matière d’IA, tout en maintenant notre engagement en faveur d’une prise en charge complète des protocoles qui répond à l’évolution des besoins des clients.

Grâce à la collaboration avec nos premiers utilisateurs, nous suivons l’évolution rapide des demandes du marché tout en protégeant les intérêts de nos clients. Cette approche centrée sur le client permet aux organisations d’adopter en toute confiance des capacités d’IA de pointe tout en maintenant les postures de sécurité robustes que les entreprises modernes exigent.

Découvrez comment Axway intègre l’innovation de pointe en matière d’IA avec Amplify AI Gateway.