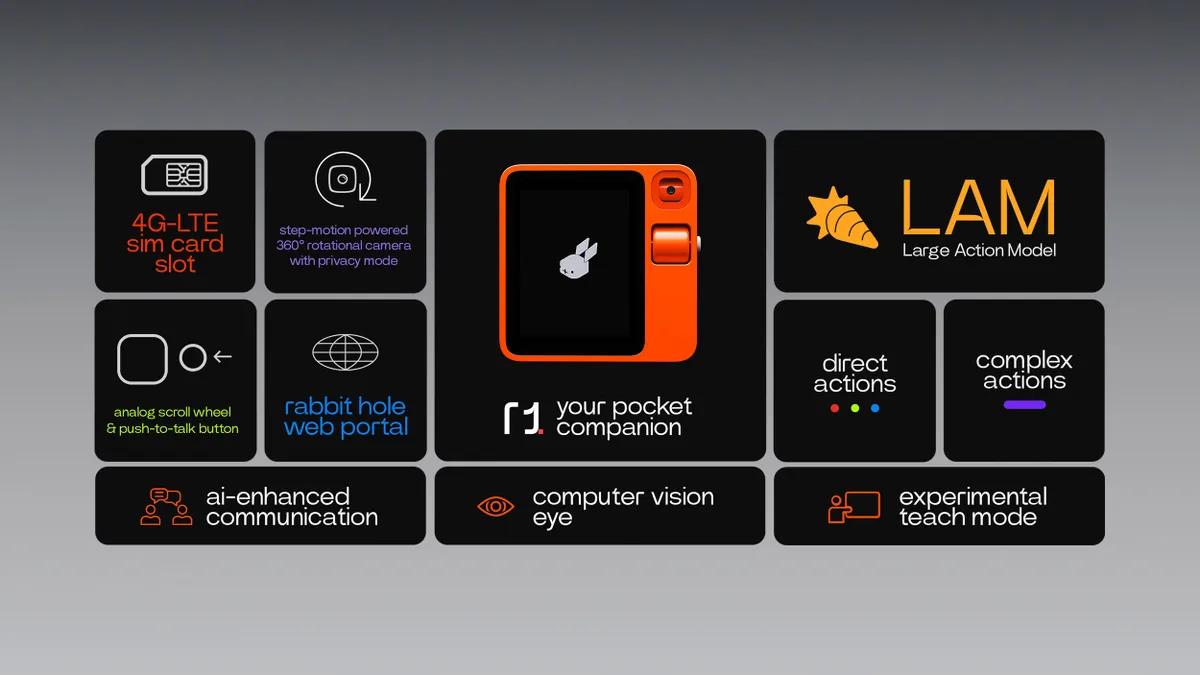

Le CES vient de fermer ses portes et l’on peut sans aucun doute décerner la palme de l’innovation à Rabbit R1. Ce petit lapin malin, qui se loge dans la poche, nous a été présenté dans une keynote digne de la présentation de l’iPhone et vient confirmer nos prédictions 2023 sur la multiplication des assistants dopée à l’IA générative (ChatGPT, Bard, etc).

Le Rabbit R1 est un assistant virtuel qui apprend à gérer vos tâches numériques. Il suffit d’appuyer sur un bouton, de donner une commande vocale et de laisser les scripts automatisés (appelés “rabbits”) faire le travail à votre place.

Mais ce qui, à mon sens, provoque un étonnement spécifique, ce n’est pas que ce petit animal se nourrisse d’IA générative basée sur des LLM. C’était attendu, ça ne fait qu’arriver un peu plus tôt que prévu. Non, ce qui nous interpelle se passe au niveau de l’interconnexion de ces LLM aux services sous-jacents.

La révolution au cœur de Rabbit R1

En effet, on imaginait tous que, de manière très classique, ces LLM se connecteraient aux grands services d’internet par le biais d’APIs métier orientées IA. Cela reste le modèle cible d’un écosystème où l’IA générative se positionne au centre du dispositif, consommant et composant les différents services (calcul d’itinéraire, réservation de train, accès aux comptes, etc.).

Mais le problème est que ce modèle cible pêche par le retard de la mise à disposition de ces interfaces API et de leur exposition.

Pour pallier ce retard et pour autant proposer un service de qualité, la startup de Santa Monica, mère de RabbitR1, et qui a déjà pré-vendu plus de 10 000 Rabbit R1 durant le CES (alors que les prévisions livrées aux analystes se basaient sur 500) va donc compléter ce LLM d’un LAM, un « Large Action Model ».

Ce LAM est le bras armé de l’intelligence du Rabbit.

LAM vs LLM – comprendre la différence

Contrairement aux LLM qui créent de l’intelligence à travers des stocks de données et des API d’accès aux services, les LAM sont, elles, capables de reproduire l’activité d’un humain sur une interface classique (interface WEB, interface d’application).

Ce tableau, inspiré de celui partagé par SuperAGI sur X, illustre plus en détail les distinctions entre LAM et LLM.

| Aspects | LLMS | LAMS |

| Large Language Models | Large Agentic(or Action) Models | |

| Core Function | Language understanding and generation | Language understanding, generation, complex reasoning and actions |

| Primary Strength | Formal linguistic capabilities, generating coherent and contextually relevant text | Advanced linguistic capabilities / (Formal + Functional) combined with multi-hop thinking and generating actionable outputs |

| Reasoning Ability | Limited to single-step reasoning based on language patterns | Advanced multi-step reasoning, capable of handling complex, interconnected tasks & goals |

| Contextual Understanding | Good at understanding context within text, but limited in applying external knowledge | Superior in understanding and applying both textual and external context |

| Problem-Solving | Can provide information and answer questions based on existing data | Can propose solutions, strategic planning, make reasoned decisions and act autonomously |

| Learning Approach | Primarily based on pattern recognition from large datasets | Integrates pattern recognition, self-assessment & learning with advanced learning algorithms for reasoning and decision-making |

| Application Scope | Suitable for tasks like content creation, simple Q&A, translations, chatbots, etc. | Suitable for building autonomous applications that requires strategic planning, advanced research, and specialized task execution |

| Towards AGI | A step in the journey towards Artificial General Intelligence, but with limitations | Represents a significant leap towards achieving Artificial General Intelligence |

Un peu à la manière des antédiluviens outils de screen scraping, les propriétaires du Rabbit R1 vont lui confier leurs identités numériques (code d’accès banque, etc.) pour que les LAM se connectent au site de la banque afin de consulter les soldes des comptes et ainsi ne proposer que des offres de voyages qui entrent dans le budget par exemple.

Cette nouvelle manière d’accéder aux services doit nous interpeller à plusieurs niveaux, car si cette technologie coûteuse au niveau IA (GPU) est nécessaire, c’est que :

- Les fournisseurs de services n’ont pas été assez rapides dans l’ouverture API de métier de leurs cœurs de système ;

- Que les quelques services exposés ne le sont pas de façon à être découverts et consommés par les IA.

Peut-on imaginer que ces technologies LAM retournent les discours académiques sur l’intégration et offrent une prime au retardataire et aux mauvais élèves qui n’ont pas correctement APIsé leur SI?

En reviendrait-on à l’archaïque intégration par écrans, tant raillée par les puristes ? Cette méthode utilisée par les LAM ne peut-elle pas suffire à l’ouverture des services ?

C’est mal connaître le fonctionnement de ces outils.

L’APIsation devient plus urgente encore

Les LAM ne sont pas initialement conçues pour pallier l’absence d’API d’accès aux services. Elles sont conçues pour décomposer des processus en étapes actionnables.

Le coût d’utilisation de ces outils pour accéder à une simple information comme l’accès aux comptes est bien plus coûteux et complexe qu’un simple appel API.

Il va donc se créer une sorte de concurrence d’accès aux services, les plus simples étant priorisés par les IA génératives qui iront au plus court pour permettre une réponse plus rapide. Et les services bien APIsés et bien exposés via une marketplace orientée IA rencontreront indéniablement plus de succès que ceux qui nécessiteront de lourdes minutes CPU pour être actionnés.

L’APIsation du système d’information doit donc être la priorité numéro 1 des DSI pour les prochaines années. Une APIsation ouverte aux développeurs humains et, bien entendu, aux IA.

Chez Axway, nous aidons les entreprises en fournissant les solutions qui permettent d’effectuer cette APIsation en toute sécurité et en toute souveraineté, mais nous pouvons aussi vous accompagner sur la conception et la mise en musique de votre stratégie digitale.

Découvrez notre baromètre « Marketplace : Stratégie d’exposition et gouvernance des API » en cliquant sur le lien ci-dessous.